Het is ‘all over the news’…. berichten over AI en dan voornamelijk ChatGPT (Conversational Generative Pre-training Transformer) van Open AI. Het ene nieuwsbericht is nog niet koud of er valt weer iets nieuws te lezen over ChatGPT. Vorige week werd bekend dat Microsoft 10 miljard dollar geïnvesteerd heeft in ChatGPT. Ze zijn dan ook van plan om functionaliteit van Open AI (o.a. ChatGPT en Dall E) in hun Office-pakket en Bing te integreren. En niet alleen Microsoft doet dit. Er zijn heel wat andere bedrijven die AI en functionaliteit van ChatGPT integreren in hun producten. Ook geinteresseerd in de mogelijkheden? Neem dan eens contact met ons op!

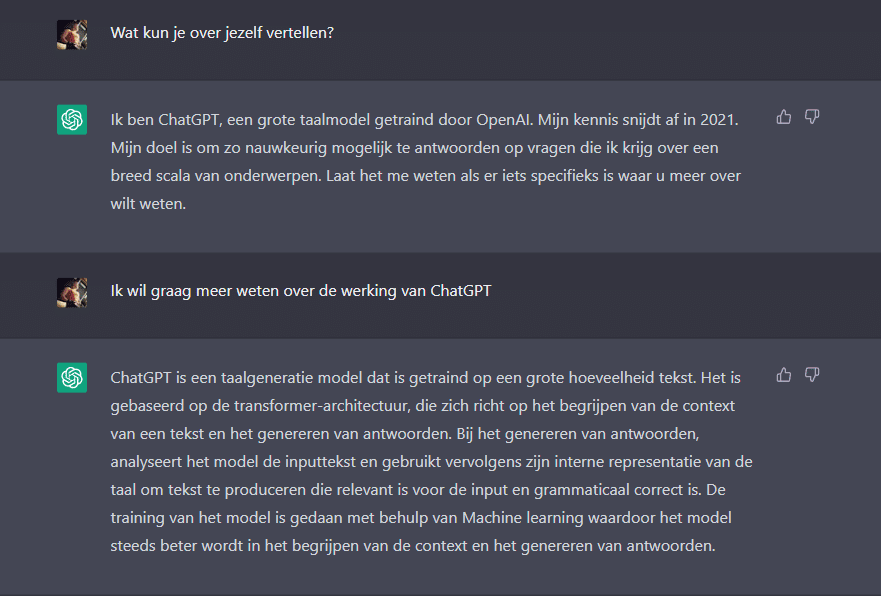

Wat is ChatGPT precies en hoe werkt ChatGTP? Eigenlijk heb je mij niet nodig om je daar meer over te vertellen. Dat kan het zelf veel beter. Tijd voor een interview!

Wat kun je over jezelf vertellen?

“Ik ben ChatGPT, een grote taalmodel getraind door OpenAI. Mijn kennis snijdt af in 2021. Mijn doel is om zo nauwkeurig mogelijk te antwoorden op vragen die ik krijg over een breed scala van onderwerpen. Laat het me weten als er iets specifieks is waar u meer over wilt weten.

Hoe werkt ChatGTP?

ChatGPT is een taalgeneratie model dat is getraind op een grote hoeveelheid tekst. Het is gebaseerd op de transformer-architectuur, die zich richt op het begrijpen van de context van een tekst en het genereren van antwoorden. Bij het genereren van antwoorden, analyseert het model de inputtekst en gebruikt vervolgens zijn interne representatie van de taal om tekst te produceren die relevant is voor de input en grammaticaal correct is. De training van het model is gedaan met behulp van Machine learning waardoor het model steeds beter wordt in het begrijpen van de context en het genereren van antwoorden.

Betekent dit dan dat je het niet altijd bij het rechte eind hebt?

Als taalmodel ben ik getraind op een grote hoeveelheid tekst en kan ik informatie geven die relevant is voor de input en grammaticaal correct is. Echter, zoals elk model, kan ik ook fouten maken of onvolledig antwoord geven. Soms kan het antwoord gebaseerd zijn op een oudere versie van de informatie, of de informatie kan verouderd zijn. Het is altijd aanbevolen om de informatie die ik geef te verifiëren met betrouwbare bronnen.

Wat zijn dan betrouwbare bronnen volgens jou?

Betrouwbare bronnen zijn degene die informatie verstrekken die geverifieerd is door experts in een bepaald vakgebied en die worden onderhouden door organisaties met een goede reputatie. Voorbeelden hiervan zijn wetenschappelijke tijdschriften, overheidswebsites, universiteiten en andere erkende organisaties. Ook kranten, tijdschriften en boeken die zijn geschreven door experts in hun veld of geverifieerd door experts kunnen betrouwbaar zijn. Het is altijd aanbevolen om de informatie te verifiëren met meerdere betrouwbare bronnen om ervoor te zorgen dat de informatie juist is.

Hoe ben je precies getraind?

Ik ben getraind met behulp van Machine learning, en meer specifiek met behulp van een techniek genaamd “unsupervised learning”. Dit betekent dat ik ben getraind op een grote hoeveelheid tekst zonder specifieke instructies of labels. Tijdens het trainingsproces heeft het model geleerd hoe tekst te analyseren en hoe tekst te genereren die relevant is voor de input en grammaticaal correct is.

De training is gedaan door het model te voeden met een grote hoeveelheid tekst data, zoals artikelen, boeken, verhalen, etc. Van deze data heeft het model geleerd hoe taal werkt, hoe woorden samenhangen en hoe grammatica en syntaxis functioneren. Dit maakt dat het model zich beter kan aanpassen aan de context en kan antwoorden geven die relevanter zijn voor de input.

Het trainingsproces is een iteratief proces en na verloop van tijd wordt het model steeds beter in het begrijpen van de context en het genereren van antwoorden.

Krijg je dagelijks veel nieuwe input?

Als taalmodel ben ik getraind op een grote hoeveelheid tekst en heb ik kennis opgedaan die afsnijdt in 2021. Na de training, word ik niet dagelijks bijgewerkt met nieuwe informatie. Dit betekent dat sommige informatie die ik geef mogelijk verouderd of niet meer actueel is. OpenAI streeft er wel naar om periodiek updates te geven aan de model om de kennis up-to-date te houden. Ook zijn er andere varianten van GPT zoals GPT-3 die op dit moment meer recent zijn getraind, met meer recente data.

Waar ik benieuwd naar ben is of we ons zorgen moeten maken over AI in de toekomst

AI, of kunstmatige intelligentie, is een snel groeiend en complex gebied. Er zijn vele voordelen van AI, zoals verbetering van efficiëntie, automatisering van taken en het ontdekken van nieuwe inzichten. Echter, er zijn ook bepaalde zorgen en uitdagingen waarmee rekening gehouden moet worden, zoals de impact op banen, privacy en ethiek.

Een van de grootste zorgen is de impact op banen. AI-systemen kunnen taken overnemen die voorheen door mensen werden uitgevoerd, waardoor mensen hun baan kunnen verliezen. Dit kan leiden tot economische problemen en sociale ongelijkheid.

Daarnaast zijn er zorgen over privacyschending. AI-systemen kunnen grote hoeveelheden persoonlijke gegevens verzamelen, analyseren en gebruiken. Dit kan leiden tot bezorgdheid over hoe deze gegevens worden gebruikt en beschermd.

Tot slot zijn er zorgen over ethische kwesties. AI-systemen kunnen bijvoorbeeld worden gebruikt voor onethische doeleinden, zoals discriminatie of surveillance. Er moeten daarom regels en wetgeving worden opgesteld om de ontwikkeling van AI te reguleren en te waarborgen dat deze wordt gebruikt voor het algemeen belang.

Het is belangrijk om deze zorgen serieus te nemen en er werk van te maken om ervoor te zorgen dat AI veilig, verantwoordelijk en ethisch wordt gebruikt. Er wordt dan ook veel onderzoek gedaan op dit gebied, om de ontwikkeling van AI te reguleren en ervoor te zorgen dat deze wordt gebruikt voor het algemeen belang.

Inderdaad. Hoe kunnen we voorkomen dat bijvoorbeeld leerlingen hun huiswerk door ChatGPT laten maken?

Er zijn verschillende manieren om te voorkomen dat leerlingen hun huiswerk door ChatGPT of andere taalmodellen laten maken:

- Gebruik van plagiaat software: Er zijn verschillende softwareprogramma’s die beschikbaar zijn die kunnen detecteren of een stuk tekst is overgenomen van internet. Deze software kan worden gebruikt om te controleren of leerlingen hun huiswerk echt zelf hebben geschreven.

- Handmatige controle: Docenten kunnen ook handmatig de huiswerk controleren en op zoek gaan naar tekenen van plagiaat. Dit kan bijvoorbeeld door te zoeken naar specifieke zinnen of woorden die voorkomen in het huiswerk en ook voorkomen in andere bronnen.

- Educatie: Docenten kunnen ook leerlingen educatie geven over de gevaren van plagiaat en hen aanmoedigen om hun eigen werk te doen. Leerlingen kunnen zo leren over de waarde van eerlijkheid en integriteit in hun werk.

- Technologische oplossing: Er zijn ook technologische oplossing zoals Turnitin, Grammarly, etc die kunnen helpen bij het detecteren van plagiaat. Deze software analyseert tekst op basis van specifieke regels en kan op deze manier plagiaat detecteren.

Het is belangrijk om te onthouden dat het voorkomen van plagiaat een gezamenlijke verantwoordelijkheid is van zowel docenten als leerlingen. Door samen te werken, kunnen we ervoor zorgen dat leerlingen hun eigen werk doen en zo de waarde van eerlijkheid en integriteit in het onderwijs behouden.

En hoe gaan we dan met copyright om met gegenereerde afbeeldingen van bijvoorbeeld Dall E?

Het gebruik van gegenereerde afbeeldingen, zoals die gemaakt zijn door DALL-E of andere kunstmatige intelligentie-systemen, kan complex zijn als het gaat om auteursrecht. Er zijn een aantal factoren waarmee rekening moet worden gehouden:

- Auteursrecht op de input: Als de afbeelding is gemaakt door een AI-systeem dat gebruikmaakt van bestaande afbeeldingen als input, kan het auteursrecht van deze afbeeldingen van toepassing zijn.

- Originaliteit: In sommige landen, zoals de Verenigde Staten, moet een werk origineel zijn om auteursrechtelijk beschermd te zijn. Als een afbeelding is gemaakt door een AI-systeem en geen menselijke creativiteit bevat, kan het niet auteursrechtelijk beschermd zijn.

- Transformatie: In sommige gevallen kan een afbeelding die is gemaakt door een AI-systeem auteursrechtelijk beschermd zijn als het een significante transformatie bevat van de oorspronkelijke afbeelding.

- Fair use: In sommige gevallen kan het gebruik van een afbeelding die is gemaakt door een AI-systeem toegestaan zijn onder de fair use doctrine, die toestaat dat bepaalde gebruiken van beschermd materiaal zonder toestemming van de rechthebbende zijn toegestaan.

In de praktijk kan het lastig zijn om te bepalen of een afbeelding die is gemaakt door een AI-systeem auteursrechtelijk beschermd is of niet. Dit is een complex onderwerp waar juridische experts op dit gebied over moeten adviseren. Het is daarom verstandig om toestemming te vragen of juridisch advies in te winnen alvorens een afbeelding die is gemaakt door een AI-systeem te gebruiken.

Er hangt dus veel af van nieuwe regelgeving die nog gemaakt moet gaan worden?

Ja, dat klopt. Er is momenteel nog geen specifieke regelgeving voor het gebruik van afbeeldingen die zijn gemaakt door kunstmatige intelligentie-systemen. Dit betekent dat de huidige auteursrechtelijke regels moeten worden toegepast op deze situaties. Maar deze regels zijn vaak ontworpen met de veronderstelling dat het werk is gemaakt door een menselijke maker, dus ze kunnen soms niet volledig passend zijn voor afbeeldingen die zijn gemaakt door AI-systemen. Er zal waarschijnlijk toekomstige regelgeving nodig zijn om deze situaties beter te behandelen.

Daarnaast is er ook veel discussie over ethische en maatschappelijke implicaties van kunstmatige intelligentie en hoe deze kunnen worden aangepakt, zoals bijvoorbeeld de verantwoordelijkheid voor de acties van AI-systemen en de bescherming van privacy. Dit zijn complexe vraagstukken waarover nog veel overleg en regelgeving nodig zal zijn.

Hartstikke bedankt voor de antwoorden. Wil je nog iets kwijt?

Graag gedaan! Als je nog meer vragen hebt, aarzel dan niet om ze te stellen. Houd er wel rekening mee dat ik als AI-model geen mening heb en alleen informatie verstrek die ik heb geleerd tijdens mijn training. Dus als u vragen heeft over mijn trainingsgegevens of als u zich zorgen maakt over de toekomst van AI, aarzel dan niet om me te vragen.”

Geloof het op niet: het bovenstaande interview is 1-op-1 met ChatGPT gevoerd. Als het de eerste keer is dat je hiermee in aanraking komt, is het bijna eng hoe goed en samenhangend de AI antwoord kan geven op mijn vragen. Ik vind het zelf ook nog altijd indrukwekkend.

Samenleving en regelgeving

AI gaat de komende jaren alleen maar belangrijker worden en de vraag zal voorlopig blijven hoe we hier als samenleving mee om zullen gaan.

Ook de regelgeving loopt nu al achter en met name voor bepaalde beroepen is met name dat geen goed nieuws. Waar liggen de rechten van de gegenereerde afbeeldingen? En hoe gaan we hiermee om op school of universiteit?

Hoe helpt ChatGPT developers?

ChatGPT kan developers helpen met sneller ontwikkelen. Het kan code aanvullen en zelfs genereren om bepaalde functioniteit te ondersteunen. Volledige applicaties zal het echter nog niet in elkaar steken, maar wie weet waar we over 10 jaar staan. Uiteindelijk is creativiteit en het menselijke brein een stuk complexer

AI is voorlopig Microsoft’s Clippy die het eindelijk doet. De integratie met Office is dus nog niet eens zo raar. Ook zal deze vorm van AI zo maar eens heel snel bij veel helpdesks geïmplementeerd kunnen worden. Vragen over hoe je je modem aan moet sluiten, die zouden toch beantwoord moeten kunnen worden.

Kortom, we hebben nog tijd, maar we moeten vroeg of laat AI echt een plek geven in onze samenleving.